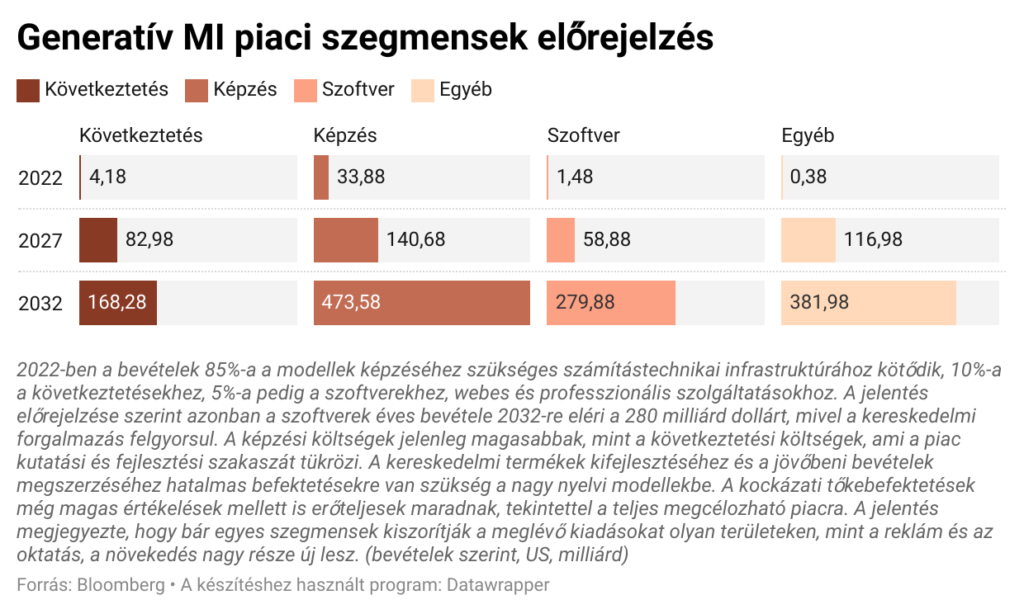

(Kiemelt kép: Unsplash)

Nehéz elhinni, hogy még mindig nem telt el egy év a ChatGPT elindítása óta, és máris láthattuk, ahogy a generatív mesterséges intelligencia viharszerűen meghódítja a világot. A nagy nyelvi modellektől (LLM) a stabil diffúziós modellekig a képgeneráláshoz, valóban figyelemre méltó, hogy mire képes ez az új jövőtechnológia. Ez az első alkalom, amikor az MI-t kézzelfoghatónak érezhetjük, mintha az, amiről eddig csak a sci-fiben álmodtunk, most ténylegesen valósággá vált volna. Ez természetesen elgondolkodtatta az üzleti vezetőket, hogy vajon mit tud vagy mit nem az MI az üzleti folyamataik átalakításában. Bizonyára sok klassz dolog van, amit a MI-val megtehettünk, de van néhány tévhit is, ami körüllengi a világot, és amivel kapcsolatban az üzleti vezetőknek óvatosnak kell lenniük. Érdemes megosztani néhány alapvető dolgot, amit az MI megtehet, ugyanakkor mérsékeljük az elvárásokat, hogy óvatosak legyünk azzal kapcsolatban, hogy mit nem tud (még) megtenni.

A mesterséges intelligencia képes összefoglalni dolgokat

Talán az egyik legklasszikusabb felhasználási eset, melyet minden iparágban hallunk, az a képesség, hogy különösen a nagy nyelvi modellek (LLM) segítségével sok információt sokkal emészthetőbbé sűrítsen a mesterséges intelligencia. Például egy értekezletről átírt párbeszédet vehetünk, és az MI segítségével összefoglalhatjuk az információt néhány kulcsfontosságú pontba. Ezenfelül egy nagyméretű jogi dokumentumot is átvehetünk, és egy LLM segítségével kiemelhetjük a legfontosabb információkat belőle rögvest. Természetesen mindig óvatosan kell ellenőrizni, hogy az adott LLM kimenete helyes-e, de ez rengeteg időt takaríthatunk meg számos különböző üzleti kontextusban. Nagymértékben számíthatunk arra, hogy ez a nóvum idővel egyre több iparágban fog teret is nyerni.

Az MI soha nem lehet biztos semmiben

Talán az egyik legnagyobb tévhit az LLM-ekkel kapcsolatban, hogy tudnak gondolkodni. A valóságban az LLM-ek egyszerűen csak „szójósló gépek”, bár ezek a modellek olyan érdekesen pontosak, hogy szinte úgy tűnik, mintha valódi tudatot emulálnának. Mivel az LLM-ek a szavak közötti valószínűségekkel dolgoznak, soha nem lehetünk igazán biztosak a végső kimenetükben. Ironikus módon azonban mindig nagyon magabiztos kimenetet fognak produkálni. Ezeket a magabiztos, de hamis állításokat hallucinációknak nevezzük. Tekintsük a következő mondatot: „Szeretek reggelente ______ inni.” Ha erre emberként kellene válaszolnunk, talán megvakarhatnánk a fejünket. Azt eléggé meg tudjuk állapítani, hogy az üres rész valamilyen folyadék, de pontosan milyen folyadékról van szó? Kávé? Tea? Víz? Az emberhez hasonlóan az LLM sem lehet biztos a válaszban; azonban az emberrel ellentétben az LLM nem fogja azt mondani, hogy „nem tudom”. Ehelyett magabiztosan ad egy választ, csakhogy mi tudjuk, hogy az LLM nem lehet biztos a válaszában. A ChatGPT próbálja kitölteni ezt az üres helyet, például magabiztosan „kávé”-ként, ugyanakkor nem jelzi, hogy esetleg rosszul töltötte ki. Ezt a túlságosan magabiztos „találgatást” ismét hallucinációnak nevezzük, de a következő MI változatokkal már állítólag csökkenthetjük ezeket a hallucinációkat.

A mesterséges intelligencia megalapozott válaszokat tud adni a kibővített kontextus segítségével

Az előző pontban megjegyeztük, hogy egy LLM nem lehet különösebben biztos abban, hogy hogyan töltse ki az alábbi mondat üres helyét: „Szeretek reggelente ______ inni”. Mi azonban bővíthetjük az LLM tudását azzal, hogy további kontextust biztosítunk számára. Az MI-közösségben ezt retrieval augmented generation (RAG) néven emlegetjük. Ha arra kérnénk az LLM-et, hogy töltse ki a fenti üres részt minden további kontextus nélkül, akkor biztosan adna egy választ, de ez a válasz lehet, hogy hallucinált lenne. Most tegyük fel, hogy adtunk az LLM-nek némi kiegészítő kontextust. Változtassuk meg, amit az LLM-nek a következőkkel adhatnánk meg: A nevem Kovács Ákos. Minden reggel szeretek egy hideg kávét inni a Starbucksból. Ezen információk felhasználásával töltse ki a következő mondat üres helyét: „Szeretek reggelente ______ inni”. Most, hogy az LLM kapott némi nagyon konkrét kontextust, kellőképpen ki tudja tölteni az üres részt. Ha ezt kipróbáljuk a ChatGPT-ben, látni fogjuk, hogy helyes választ kapunk. Természetesen ettől még nem lesz teljesen biztos az LLM kimenete a válaszban. Ne feledjük, hogy az LLM a szavak közötti valószínűségeket értékeli. A RAG-folyamatban egyszerűen csak növeljük a kimenet valószínűségét egy helyesebb válasz előállításának valószínűségét. Ez nem növeli a bizonyosság valószínűségét 100%-ra, de mindenképpen elég sokat segíthet!

Az MI nem tud magától új dolgokat kitalálni

Bár a RAG-folyamat sokat segíthet a MI-nak abban, hogy pontosabb választ adjon, a RAG-folyamat nem automatikus. Más szóval, az MI-technológiák, mint például az LLM-ek, nem képesek arra, hogy maguktól tanuljanak meg dolgokat. Ezeket az MI-modelleket egy adott pillanatfelvételen kapott információk alapján képzik ki, szinte mintha a tudásuk ehhez a rögzített időponthoz lenne teljesen rögzítve. Amikor további kontextust adunk az LLM-nek, ez a kontextus segíthet pontosabb kimenetet produkálni, de ez a RAG-kontextus valójában NEM változtatja meg magát a mögöttes modellt. Azért hozzuk ezt elő, mert bár a RAG-folyamat nagyszerű lehet, nem mondhatjuk magának a MI-nak, hogy keresse meg magának ezt az információt. Még az olyan esetekben is, mint a Bing Chat, ahol úgy tűnik, hogy az LLM keres(ne) az interneten, valójában nem a modell „kúszik” az interneten. Inkább az információ kerül az LLM-hez, és az LLM értelmezi azt, amit elhoztak neki. Még nem értük el a szuperintelligencia Skynet-szerű szintjét, ahol ezek a mesterséges intelligencia modellek képesek lennének önállóan rájönni a dolgokra.

A mesterséges intelligencia nagyszerű kódolási asszisztens lehet

Figyeljünk nagyon a megfogalmazásra ennél a konkrét esetnél. Nagyon szándékosan használjuk a „lehet” szót ennél a pontnál. Nem titok, hogy az emberek megtalálták a módját annak, hogy az LLM-eket kódolási célokra használják fel, és hogy teljesen egyértelmű legyen, az LLM-ek nagyszerűek lehetnek a kódírás segítésére. Legyen szó a közös feladatok automatikus kitöltéséről vagy a hibák elhárításának segítéséről, az MI nagyon hasznos eszköz lehet a kódolásban. A helyzet az, hogy az LLM-ek nem tökéletesek ebben a feladatban. Amellett, hogy korlátozottak azáltal, hogy egy pillanatnyi időpillanatra vonatkozó információval képezték ki őket, személyes tapasztalatunk szerint az LLM-ek hajlamosak elég sokat hallucinálni, amikor arra kérik őket, hogy nagyon „árnyalt helyzetekben” írjanak kódot. Ne feledjük, az LLM-ek csak annyira jók, amennyire a kontextus, amit mi biztosítunk nekik. Ha van egy hiba, mely a vállalatunk nagyon specifikus rendszerével kapcsolatos valamiből ered, az LLM nem lehet tisztában a rendszerünk részleteivel, és így végül hallucinálni fogja a választ. Ez nem azt jelenti, hogy az MI nem lehet hasznos a kódírás során, de inkább asszisztensként tekintsünk rá, mint bármi másra.

Az MI nem lehet biztos abban, hogy egy másik tartalmat mesterséges intelligencia hozott létre

Ez az egyik olyan pont, ahol a kutatók ide-oda ingadoznak. Valójában az OpenAI egy ponton kiadott egy eszközt, mely segít a tanároknak meghatározni, hogy egy házi feladatot a ChatGPT segítségével hoztak-e létre. Végül az OpenAI visszavonta ezt az eszközt, és ha megérti az MI megoldások mögöttes matematikáját és architektúráját, akkor vitathatjuk, hogy gyorsan eljutunk egy olyan ponthoz, ahol ez szó szerint lehetetlen lesz. Tekintsük a jelenleg a piacon lévő legfejlettebb LLM-eket, beleértve az OpenAI GPT-4-et és az Anthropic Claude 2-t. Ezek az LLM-ek képesek olyan kimeneteket produkálni, melyek rendkívül emberinek tűnnek, és ez azért van, mert a mögöttes architektúra elképesztő pontossággal képes felmérni a szavak közötti valószínűségeket. Óvatosan a tényleges és a mesterséges tudatosság közötti határvonalat taposva nem lehet nem elgondolkodni azon, hogy vajon az emberi beszédet is meg lehet-e jósolni a szavak közötti valószínűségek formájában. Ezen a ponton egy LLM és egy ember végeredménye valószínűleg megkülönböztethetetlen, így egyetlen eszköz sem lenne képes véglegesen kijelenteni: „Ezt az MI készítette; ezt egy ember”. Mindezzel azt akarjuk mondani, hogy ne dőljünk be egy olyan eszköznek, mely azt állítja, hogy meg tudja különböztetni, hogy mit generált a mesterséges intelligencia, és mit nem. Talán a primitívebb MI-megoldások esetében képes valamilyen szintű értékelést végezni, de a GPT-4-hez hasonló LLM-ekkel már vitathatatlanul túlléptük a megkülönböztethetőségnek ezt a pontját.

A mesterséges intelligenciát más szoftverfolyamatok is segíthetik

Míg a legtöbb ember jobban ismeri az LLM-ekkel való interakciót egy olyan felhasználói felületen keresztül, mint a ChatGPT, a mesterséges intelligencia iparág szinte minden nagyobb szereplője kínál programozott megoldásokat olyan dolgokon keresztül, mint az API-k. Ez azt jelenti, hogy az MI technológiát új és meglévő szoftverfolyamatokba is beépíthetjük. Valójában a legtöbb MI-startup pontosan ezt teszi. Konkrétan, sok MI-startup használja az olyan szolgáltatók API-jait, mint az OpenAI vagy az Anthropic, mint „backend-motor” az MI-igényeik támogatására. (Ezért is kell óvatosnak lennünk azzal, hogy a cégünk kivel köt üzletet, mivel valószínűleg egy 4. féllel lépnek kapcsolatba a színfalak mögött!). Ismételjük, nem lehet eléggé hangsúlyozni, hogy az MI-t mindig mérsékelni kell a hallucinációk miatt. Bár a mesterséges intelligencia képes kódrészleteket előállítani olyan dolgokhoz, mint például bizonyos információk lekérdezése egy adatbázisból, személy szerint én soha nem támaszkodnék egy LLM-re egy ilyen feladatban. Mivel nem lehetünk 100%-ig biztosak abban, hogy a kód helyes lenne, nem lenne körültekintő ilyen módon az MI-ra támaszkodni. Ez nem azt jelenti, hogy soha ne építsük be az MI-t a szoftverrendszereinkbe! Még mindig vannak nagyszerű felhasználási esetek, ahol a mesterséges intelligenciát programozási megoldásokban úgy használhatjuk fel, hogy az még mindig előnyös, ugyanakkor óvatos is legyen.

Az MI nem tudja megfelelően idézni a saját forrásadatait

Ezt a kérdést elég gyakran felteszik, és ha eddig jól figyelt, akkor megértheti, hogy miért nem lehetséges. Bár az LLM-ek egy adott pillanatfelvételen lévő információra vannak kiképezve, nem mintha a szavak közötti összes valószínűséget konkrét forrásokhoz kötné vissza. Amit az LLM csak tárol, az úgynevezett „súlyokra és torzításokra” utal. Anélkül, hogy túl mélyen belemennénk az LLM-ek mögöttes felépítésébe, lényegében rengeteg matematikai műveletből állnak, és a képzés idején ezek a súlyok és előítéletek frissülnek, hogy jobban igazodjanak a képzett információhoz. (Valójában, ha mélyen elmagyaráznánk az LLM felépítését, megdöbbennénk, hogy a matematika elég kezdetleges ahhoz, hogy szinte varázslatosnak tűnjön, hogy az LLM-ek ennyi mindenre képesek!). Ez minden, ami egy LLM-hez tartozik. Nincs közvetlen kapcsolat a forrásinformációhoz, így ha megkérnénk, hogy idézze a saját forrását, legfeljebb hallucinációt kapnánk. Valójában úgy vélhetjük, hogy bizonyos LLM-ek, mint a ChatGPT, úgy lettek finomhangolva, hogy azt mondják, hogy nem lehet felfedni a forrásaikat, ami szerintünk jobb válasz, mint egy hallucináció. De nem lehetetlen hallucinált választ kapni. Van az a hírhedt forgatókönyv, amikor egy ügyvéd egy LLM-et használt arra, hogy hivatkozzon egy forrásra egy jogi ügyben, és kiderült, hogy az idézett forrás hallucinált és végül hamis volt. Vigyázzon, nehogy Ön is ebbe a csapdába essen!

A mesterséges intelligencia fantasztikus módja lehet a saját tudásunk bővítésének

Hasonlóan ahhoz a ponthoz, ahol az MI jó asszisztens lehet a kódírásnál, a mesterséges intelligencia egyszerűen kiváló asszisztens lehet bármilyen tudásfeladatban is. Személy szerint az olyan LLM-eket, mint a ChatGPT, egyfajta „keresőmotorként” használhatjuk általános tudásbeli kérdésekhez. Például kiválóan ad definíciókat a szavakhoz, és nagyszerű, ha további kérdésekkel követve részletesebb válaszokat kapunk. Olyan, mintha egy nagy tudású baráttal interakcióba lépnénk. Míg az internetes keresőmotorok a legfrissebb és leglényegesebb információkat nyújthatják, a beszélgetés oda-vissza áramlását egy csupasz keresőmotor nem tudja felülmúlni. Persze ennél a pontnál már nem kell emlékeztetni, hogy vigyázzunk a hallucinációkkal. Míg az LLM talán hasznosabb lehet olyan történelmi eseményekről és helyszínekről, mint az ókori Róma, addig ha megkérdeznénk tőle, hogy milyen a mai időjárás, biztosan hallucinált választ kapnánk. Ha mégis helyes választ ad vissza, az megint csak azért lesz, mert az LLM-et RAG módon bővítik, NEM azért, mert az LLM képes volt maga levezetni ezt az információt. Óvakodjunk attól is, hogy az LLM-eket kifejezetten matematikai problémákra használjuk. Ne feledjük, ezeket az LLM-eket arra képezték ki, hogy valószínűségeket keressenek a szavak között, tehát nem történik semmilyen matematikai számítás, amikor egy matematikai feladatot adnak neki. Az elmúlt hónapokban a népszerű LLM-eket, például a ChatGPT-t látszólag úgy bővítették, hogy jobban kezeljék a matematikai problémákat, de nem világos, hogyan teszik ezt. Mindenesetre továbbra is megpróbálnánk elkerülni az összetett matematikai problémák megoldását egy LLM-mel.

Az MI nem veheti át a munkánkat (még)

Igen, a nagy kérdés, ami mindenkit foglalkoztat! Valójában, ha teljesen őszinték akarunk lenni, a mesterséges intelligencia felhasználható az emberi munkaerő csökkentésére, de biztosan nem tartunk ott, hogy a legtöbb ember munkáját megszüntesse. Ha figyelmesen végigolvasta a cikk információkeresésről szóló részeit, akkor felismerheti az MI legnagyobb „hibáját”, ami megakadályozza, hogy mindenki munkáját elvegye: a mesterséges intelligenciának nincs módja arra, hogy „proaktívan tanuljon” saját maga számára. Az MI nem tud beszélni a vezérigazgatóval, és nem tudja kideríteni, mi jár a fejében. A mesterséges intelligencia nem tud beugrani a koponyánkba, hogy megértse a képzeletünkben megálmodott weboldal minden apró árnyalatát. Ebben az értelemben az MI-t egy teljesen naiv zseninek tarthatjuk: sok mindenre rá lehet venni, de a legideálisabb eredmények eléréséhez nyíltan és rendkívül konkrétan kell vele bánni.

A következő természetes kérdés: vajon eljut-e valaha is arra a pontra az MI, hogy ezeket a dolgokat meg tudja csinálni? A SzuperIntelligenciának ezt a következő szintjét mesterséges általános intelligenciának (AGI) nevezzük, és ez az oka annak, hogy a mesterséges intelligencia biztonságának védelmezői aggodalmukat fejezik ki az MI fejlődésével kapcsolatban. A cél az emberi érdekek és az MI érdekeinek biztonságos összehangolása. Anélkül, hogy tovább foglalkoznánk ezzel a témával, a lényeg az, hogy ma még nem vagyunk ezen a ponton, és valóban nem tudni, mikor érjük el a szingularitást: azt a pontot, amikor elérjük az AGI-t. Ha megértjük az MI-kutatás történetét, akkor gyorsan megtanuljuk, hogy az emberiség nem túl jó még ennek a pontnak a megjóslásában.