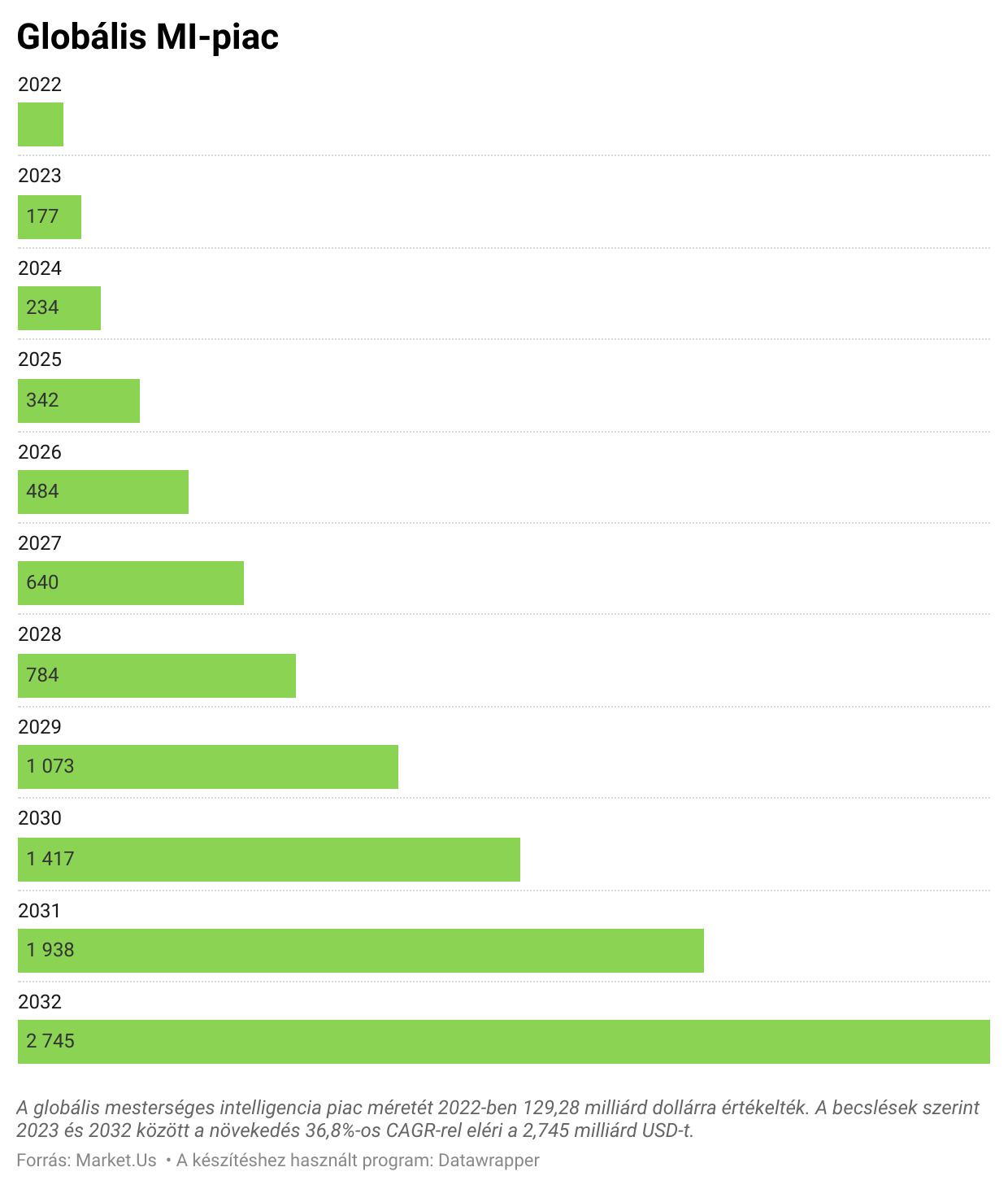

(Kiemelt kép: Unsplash+)

Van értelme a „hiba” definícióinknak, amikor az ML-ről van szó? Ha nem, akkor miért nem? Az emberek hajlamosak a gépi tanulási modelleket antropomorfizálni. Amikor egy LLM chatbottal interakcióba lépünk, olyan technikákat alkalmazunk ezekre a beszélgetésekre, melyeket más emberekkel való kommunikáció során tanultunk (meggyőzés, fogalmazás, érvelés). Ez azonban gyakran hatástalan, és nem kielégítő válaszokat eredményez. A gépi tanulás nem tökéletes (és reálisan soha nem is lesz az). „Miért mondta a modell X-et, amikor az igazság X-5 lett?”, ez egy örök téma. Mit értünk mi (és mit értenek mások) azon, amikor azt mondják, hogy egy modell hibázott, vagy kudarcot vallott, vagy hallucinált, vagy hazudott? Mielőtt erre választ kapnánk, az elejéről kell kezdenünk.

Mi az a gépi tanulási modell?

Nagyon-nagyon általános értelemben a gépi tanulási modell egy olyan algoritmus, mely elfogad valamilyen bemenetet vagy kérést, és valamilyen valószínűséggel meghatározott választ ad vissza. Az, hogy hogyan dönti el, hogy mi legyen a válasz, nagyon különböző lehet (használhat döntési fát, neurális hálózatot, lineáris regressziót vagy a gépi tanulás bármely más típusát). A modell létrehozásához olyan mintaadatokkal kezdünk, melyek tükrözik a keresett eredményeket. A bemeneti minták sokfélék lehetnek, a generatív mesterséges intelligencia esetében ezek lehetnek nagy mennyiségű, ember által írt szöveg, zene vagy kép. Más típusú ML esetében ezek lehetnek nagy adathalmazok, melyek például tárgyak jellemzőit, vagy képek vagy szövegek kategóriákba sorolását tartalmazzák, vagy még sok más dolgot. Néha ezeket „címkézni” kell, hogy a modell megtanulja, hogy melyek azok, melyek kívánatosak vagy nem kívánatosak, vagy melyek egy adott kategóriába tartoznak, és melyek nem. Máskor a modell mintákat tanul meg az alapul szolgáló mintákban, és ezekből a mintákból saját értelmezést származtat, hogy vagy lemásolja a bemenetek jellemzőit, válasszon a lehetőségek között, csoportokra ossza a bemeneteket, vagy más tevékenységeket végezzen.

A generatív mesterséges intelligenciamodellek képzésének módjai

A generatív modellek betanításának módja sajátos, és bonyolultabb, mint egy olyan modell betanítása, mely egy válasz egyszerű valószínűségének becslésére szolgál. Ehelyett ezek a modellek sok különböző elem valószínűségét becsülik meg, és ezeket állítják össze a válaszuk létrehozásához. Az alábbiakban nagyon egyszerű magyarázatot adunk néhány olyan módszerről, mellyel ezt a képzést végezzük. (Ezek mind extrémnek tűnő leegyszerűsítések, ezért kérjük, bocsássák meg a részletesség hiányát és az esetleges általánosításokat). Amikor hangot vagy képet generálunk, akkor Generatív Adverzariális Hálózatokat használhatunk. Itt modelleket állítunk szembe egymással, az egyik modell új tartalmat generál, a másik modell pedig megpróbálja megmondani, hogy ez a tartalom egy modelltől származik-e vagy sem, oda-vissza. A két modell ezer és ezer eseten keresztül versenyez egymással, és mindkettő egyre jobb lesz a feladatában. A végén a generáló modell képes lesz olyan tartalmat előállítani, amely szinte megkülönböztethetetlen attól, amit a valóság produkálna. (Mellékhatásként a megkülönböztető modell azt is nagyon jól meg tudja állapítani, hogy egy bemenet mikor volt így ember által generált.)

Az LLM-ek és a GPT-modellekhez hasonló szöveggeneráláshoz úgynevezett transzformátorokat használunk. Ez a képzés azt jelenti, hogy megtanítjuk a modellnek, hogyan viszonyulnak egymáshoz a szavak jelentései, valamint azt, hogyan állítson elő olyan szövegtartalmat, mely közel megkülönböztethetetlen az emberi produkciótól. Az eredmények nagyon meggyőzően hangzanak, mivel a modell tudja, hogy mely szavak milyen valószínűséggel illeszkednek egymáshoz (a valószínűségek azon alapulnak, hogy a képzés során használt valódi emberi nyelv hogyan illesztette őket egymáshoz). A Dall-E-hez hasonlóan a szöveges bemenetekből történő képgeneráláshoz a Diffúziót használjuk. Ebben az esetben megtanítjuk a modellt arra, hogy a megadott szöveg alapján kiszámolja, hogy a kép milyen tulajdonságai a legvalószínűbbek. A modell lényegében egy statikus képpel indul, és a szöveg alapján alkalmaz részleteket, színeket, jellemzőket. Ez azon alapul, amit a képzési adatok alapján megtanult arról, hogy a szöveg általában hogyan felel meg a képeknek.

Ezekkel a technikákkal megtanítjuk a modelleket arra, hogy megfejtsék a bemenetekben lévő mintákat (néha olyan mintákat, melyeket mi magunk sem tudunk igazán megmagyarázni vagy felismerni), ez különösen igaz a mélytanulásra, majd a modell képes értelmezni és alkalmazni ezeket a mintákat. Mindez matematika a felszín alatt, még akkor is, ha a minták szövegben, képekben vagy sok más dologban vannak. Most, hogy ezt tudjuk, beszélhetünk arról, hogy mik a kimenetek, és mit jelent, ha a kimenet nem az, amit szerettünk volna.

Nem kívánt kimenetek

Az, amit egy gépi tanulási modell produkál, nagyon különböző lehet. A generatív mesterséges intelligencia különösen képeket, videót, hangot és szöveget állít elő minden elképzelhető fajtából. Más típusú modellek események vagy jelenségek valószínűségét, ismeretlen értékek becslését, szövegek különböző nyelvekre történő fordítását, tartalmak címkézését vagy csoportosítását és még sok mást adnak. Mindezekben az esetekben összetett matematikai számításokat alkalmaznak, hogy az adott bemenet alapján megbecsüljék a legjobb választ. A „legjobb” azonban nagyon speciális dolog. A modell létrehozása során jeleztük a modellnek, hogy milyen jellegű válaszokat szeretnénk a válaszaitól. A modell létrehozásának folyamatában megadtuk a modellnek, hogy milyen jellegű válaszokat szeretnénk, hogy a válaszai legyenek.

Mit jelent, ha olyasmit kapunk, amire nem számítottunk?

Ez legalább annyira szól rólunk, mint a modellről. Lényegében olyan, mint bármelyik termék a technológiai térben. A terméktervezők és -alkotók „felhasználói történeteket” állítanak össze, amikor valamit fejlesztenek, amit el akarnak adni az embereknek, és ez narratívákból áll, hogy ki fogja használni ezt a terméket, hogyan és miért, és mit akarnak majd kihozni belőle. Mondjuk például, hogy egy táblázatkezelő eszközt tervezünk. A felhasználói történetek segítségével Zsuzsára, a könyvelőre gondolunk, és beszélgetünk a könyvelőkkel, hogy eldöntsük, milyen funkciókra van szüksége egy könyvelőnek a táblázatkezelő szoftverében. Ezután Istvánra, az üzleti elemzőre gondolnánk, és beszélnénk a BI-elemzőkkel arról, hogy milyen funkciókra lenne szükségük. A táblázatkezelő eszköz tervezésekor mindezeket felírnánk a listára, és ez alapján terveznénk meg. Értjük így a lényeget már remélhetőleg.

Ki az igazi felhasználója egy gépi tanulási modellnek?

Ez teljesen attól függ, hogy milyen modellről van szó. Ha a modell például ingatlanjellemzők alapján jósolja meg a lakásárakat, akkor lehet, hogy ingatlanügynökök, jelzáloghitelezők vagy lakásvásárlók. Egy viszonylag specifikus modellt, melynek egyértelmű, behatárolt alkalmazási területei vannak, könnyű a felhasználóra szabni. Az adattudósok gondoskodhatnak arról, hogy ez a modell megfeleljen azoknak az embereknek az elvárásainak, akik majd azt használni fogják. Néha az előrejelzés nem lesz pontos, de ez egy matematikai probléma, és valószínűleg meg tudjuk fejteni, hogy miért történt ez. Lehet, hogy rossz adatokat adtunk meg a modellnek, vagy ez a ház például valamilyen okból kivételes, amit nem tudtunk megmondani a modellnek. Ha a modellt soha nem tanították meg arra, hogy értelmezze mondjuk egy hátsó udvari konyhakert hatását a ház árára, akkor nem lesz módja arra, hogy beépítse ezt az információt. Mi van, ha volt egy lakásárzuhanás? Ezt nemrég láthattuk élesben, és elképzelhető, hogy a modell által a zuhanás előtt megtanult minták már nem érvényesek. Egy ilyen esetben azonban két dologgal rendelkezünk: egy világos cél, melyet a modellnek el kell érnie, és mellyel az adattudósok és a felhasználók is tisztában vannak; egy számszerűsíthető módszer annak mérésére, hogy a modell közel került-e a céljához vagy sem. Ez azt jelenti, hogy világos és egyértelmű, amikor meg akarjuk határozni, hogy a modell sikeres volt-e. Miután ezt a meghatározást megtettük, megvizsgálhatjuk, hogy a modell miért tette azt, amit tett, ezt nevezik a szakmában „modell magyarázhatóságának” vagy a „modell értelmezhetőségének”.

Hogy is van ez az LLM-ek esetében?

Mit jelent ez az egész keretrendszer egy olyan dolog számára, mint az LLM? Ki a ChatGPT felhasználója? (Csak nem azt mondták ki gondolatban, hogy „mindenki”?) Amikor egy modell kimenete olyan összetett és változatos lehet, mint egy LLM-é, elkezdünk kérdéseket feltenni. A generatív MI-modelleket építő adattudósok számára, bár különböző képzési módszereket alkalmazhatnak, általában mindig olyan tartalmat próbálunk létrehozni, mely a lehető legközelebb áll a képzési adatokhoz, melyek általában emberi vagy természet által generáltak. Ennek érdekében a modellt olyan mintatartalmakon képzik ki, melyeket az emberek vagy a természet termel. Mindent megteszünk azért, hogy a modell matematikai úton megértse, hogyan és miért érzi ezt a tartalmat „valódinak”, hogy azt meg tudja ismételni. Így válik egy generatív mesterséges intelligenciamodell képessé arra, hogy hatékonyságot teremtsen, és bizonyos emberi munkát feleslegessé tegyen.

A generatív MI-modelleket építő adattudósok számára a cél olyan tartalom létrehozása, mely a lehető legközelebb áll a képzési adatokhoz, melyek általában emberi vagy természet által generált adatok. Ezek a modellek nagyjából kiválóan teljesítenek ebben a tekintetben! Ez azonban néhány buktatót is teremt. Mivel az LLM modellek olyan meggyőzően utánozzák az emberi reakciókat, a felhasználók röviden úgy gondolnak rájuk, mint az emberekre. Ez olyan, mint ahogy a gyerekek tanulnak az állatokról: megtanítjuk egy gyereknek, hogy egy négylábú, nedves orrú, szőrös lény egy kutya, de ha eléjük teszünk egy macskát, hajlamosak azt gondolni, hogy az valószínűleg szintén egy kutya, mert az alapvető tulajdonságok annyira hasonlónak tűnnek. Csak amikor elmagyarázzuk, hogy a macska más dolog, akkor kezdik értelmezni a különbségeket, és más mentális modellt építenek fel.

Mivel ezek a modellek olyan meggyőzően utánozzák az emberi reakciókat, a felhasználók rövid úton úgy gondolnak rájuk, mint az emberekre. Jelenleg úgy gondolhatjuk, hogy a nagyközönség nagy része még mindig építi ezt a különböző mentális modellt, hogy megkülönböztesse az LLM-et az embertől. (Ahogy korábban írtuk, az adattudósoknak kell lenniük a felnőtteknek, akik elmagyarázzák, hogy a kutya nem ugyanaz, mint a macska, hogy folytassuk a metaforát). Ez valójában azt jelenti, hogy az emberek, akik egy nagyon alapvető modellel (lakásárak) interakcióba lépnek, megértik, hogy ez egy korlátozott algoritmus. Inkább hasonlít egy táblázatos képletre, mint egy emberre, és ez alakítja az elvárásainkat. De amikor például a ChatGPT-t használjuk, az sok olyan jellemzőt hordoz, mintha egy emberrel csevegnénk online, és ez hatással van ránk. Ahelyett, hogy csak korlátozott dolgokat várnánk, például „emberi nyelvre hasonlító szöveget”, elkezdjük elvárni, hogy az állítások mindig pontosak legyenek, hogy az eredmények összefüggő kritikai gondolkodást tartalmazzanak, és hogy a mai hírekből származó tények visszakereshetők legyenek a modellből, még akkor is, ha például tavaly képezték ki azt.

Az emberek, akik egy nagyon egyszerű modellel interakcióba lépnek, megértik, hogy ez egy korlátozott algoritmus. De amikor például a ChatGPT-t használjuk, az sok olyan jellemzőt hordoz, mintha egy emberrel csevegnénk online, és ez hatással van ránk. Amennyiben a kritikus gondolkodás megjelenése előfordulhat a modell eredményeiben, az azért van, mert a modell megtanulta, hogy a szöveg elrendezései, melyeket mi „kritikus gondolkodásként” értelmezünk valódi emberi forrásokból, „emberibbnek” hangzanak, és ezért e célból utánozza ezeket az elrendezéseket. Amikor emberekkel beszélgetünk, az általuk elmondottakból arra következtetünk, hogy kritikus gondolkodást alkalmaznak. Ezt azonban nem tudjuk megtenni a gépi tanulással.

Emlékezzünk arra a két kulcsfontosságú elemre, amelyet fentebb leírtunk, és melyekkel a lakásármodell rendelkezik:

1. Egy világos cél, amelyet a modellnek el kell érnie, és amellyel az adattudósok és a felhasználók is tisztában vannak;

2. Egy számszerűsíthető módszer annak mérésére, hogy a modell közel került-e a céljához vagy sem.

A generatív mesterséges intelligenciával, beleértve, de nem kizárólagosan az LLM-eket, az 1. ponttal vannak problémáink, részben azért, mert a cél valójában nem olyan egyértelmű („olyan anyagot adjunk vissza, mely megkülönböztethetetlen attól, amit egy ember állítana elő”), de leginkább azért, mert az adattudósok biztosan nem kommunikálják sikeresen a felhasználókkal, hogy mi ez a cél. Az ezeken a modelleken dolgozó adattudósok a 2-es számot kapták meg, mert összetett matematikai rendszereket használnak a modellek tanítására, amikor azok kellően „valódi2 vagy emberhez hasonló tartalmat állítottak elő. De a hétköznapi felhasználónak az utcán ez sokkal nehezebb. Annak megállapítása, hogy a modell jó munkát végzett-e, sokkal inkább hasonlít a dolgozatok osztályozásához, mint egy matematikai feladat eredményének ellenőrzéséhez. A szubjektivitás ekkor lassan bekúszik a képbe.

De még ha könnyebb is lenne mérni, határozottan állíthatjuk, hogy a felhasználók, még a technikailag értő és magasan képzettek sem igazán tudják, hogy mire lettek betanítva ezek a modellek, és ezért nem tudhatják, hogy mi az, amit reálisan elvárhatnak, és mi az, amit nem. Ezért a modellnek tökéletesen megfelelő eredményeket, például egy gördülékeny, ékesszóló, tökéletesen „emberi” bekezdést, mely leírja, hogy a Hold zöld sajtból van, „hibának” fogják tekinteni. Pedig nem az (ez a kimenet elérte a képzési célokat), és ez a forrása sok zavarunknak.

Az elvárásaink kalibrálása

Ez azt sugallja, hogy kalibrálnunk kell az elvárásokat ezekkel a modellekkel szemben. Ahhoz, hogy sikeresen használhassunk egy gépi tanulási modellt, és meg tudjuk különböztetni a hibát az elvárt viselkedéstől, tisztában kell lennünk azzal, hogy a modelleket milyen feladatok elvégzésére képezték ki, és milyen jellegűek a képzési adatok. Ha igazán fantáziadúsak lennénk, akkor világos kontextussal is rendelkeznénk arról, hogy a modell mögött álló adattudósok hogyan mérték a sikert, mert ez drámaian alakítja a modell viselkedését. Ezen elemek beépítésével rendelkezik majd a szükséges kontextussal ahhoz, hogy megértse, mit jelentenek a modell eredményei, és képes lesz pontosan értelmezni azokat (az elvárásai ésszerűek lesznek, és tudni fogja, hogy teljesültek-e). És tudni fogja, hogy mit jelent valójában a „hiba”, amikor a gépi tanulásról van szó.

Mit tanulhatunk a mesterséges intelligencia hibáiból?

A mesterséges intelligencia az utóbbi időben szinte bármilyen mércével mérve nagyot lépett előre. Csendben a világunk részévé vált, működtetve a piacokat, weboldalakat, gyárakat, üzleti folyamatokat, és hamarosan a házainkat, az autónkat és mindent, ami körülvesz minket. A közelmúlt legnagyobb sikerei azonban meglepő kudarcokkal is jártak. A Tesla lenyűgözte a világot azzal, hogy piacra dobott egy önvezető autót, de aztán olyan esetekben karambolozott, melyeket egy ember is könnyedén megoldott volna. Az AlphaGo évekkel azelőtt legyőzte az emberi Go-bajnokot, hogy a legtöbb szakértő lehetséges lett volna, de teljesen összeomlott, miután az ellenfele egy szokatlan lépést kijátszott.

Ezek a kudarcok zavarba ejtőnek tűnhetnek, ha követjük az intuíciónkat, és ugyanúgy gondolunk a mesterséges intelligenciára, mint az emberi intelligenciára. A mesterséges intelligencia felveszi a versenyt a világ legjobbjaival, majd látszólag egyszerű helyzetekben kudarcot vall. A mesterséges intelligencia jelenlegi állása azonban különbözik az emberi intelligenciától, és ez a különbség olyan szempontból is fontos, hogy a valós világban kezdjük alkalmazni. Hogyan? A gépi tanulás nem általánosít olyan jól, mint az emberek. A két Tesla-baleset és az AlphaGo veresége rávilágít arra, hogy ez hogyan érvényesül a való életben. Mindegyik Tesla-baleset nagyon szokatlan helyzetben történt: egy autópálya bal oldalán megálló autó, egy nagy belmagasságú, az autópályára merőleges teherautó és egy fapalló egy felfestetlen autópályán. Az AlphaGo vesztes játékában akkor esett szét, amikor a Go-bajnok Lee Sedol egy rendkívül szokatlan lépést játszott, amelyre egyetlen szakértő sem gondolt volna.

Miért tud egyszerre zseniálisnak és ostobának tűnni egy MI?

Nos, először is, kevesebbet tud arról, hogy mi történik, mint gondolnánk. Nézzünk egy egyszerű példát a magyarázathoz. Az MI látványosan jól meg tudja különböztetni, hogy a „szekrény” szó használata egy fából készült emelvényre és az elnöki pulpitusra is utal(hat). Az emberi intelligencia megértésén alapuló intuíciónk szerint egy gépnek „értenie” kellene ezt a két szekrény szerű tárgy fogalmát ahhoz, hogy ilyen következetesen meg tudja tenni ezt a különbséget. Az emberi megközelítés a politika és a famegmunkálás megismerése révén érti meg a két különböző fogalmat. A gépi tanulásnak nem kell ezt megtennie (megnézhet 1000 olyan mondatot, mely tartalmazza a szekrény szerű tárgy szót, és melyek mindegyikét (egy ember által) úgy jelölték meg, hogy az egyik vagy a másik jelentésnek felel meg. Megtanulja, hogy milyen gyakran fordulnak elő olyan szavak, mint a „fa” vagy a „tárolás” vagy a „titkár” a közelben minden esetben. Tehát tudja, hogy amikor a „fa” szó jelen van, akkor rendkívül nagy az esélye annak, hogy egy tárolószekrényre utalunk. De ha Orbán Viktor arról kezd beszélni, hogy hogyan kezdett bele a famegmunkálásba, a mesterséges intelligencia teljesen kudarcot vallhat.

A mesterséges intelligencia egy egyszerű okból tud olyan jól működni anélkül, hogy úgy „tudna”, ahogyan az emberek „tudnak”: a gépek sokkal több gyakorló adatot tudnak feldolgozni, mint az ember. Peter Norvig, a Google kutatási vezetője a leghíresebb, aki először rávilágított erre a gondolatra „Az adatok ésszerűtlen hatékonysága” című tanulmányában és előadásában. A modern gépi tanulás általában így működik: hatalmas adathalmazokat önt át, és megtanul okos módon általánosítani, de nem ugyanolyan okos módon, mint az emberek. Ennek eredményeképpen zseniális lehet, de nagyon összezavarodhat is.

Hogyan kezeljük a mesterséges intelligenciát a való világban?

Játsszunk az MI erősségeire

Miért van a Facebooknak olyan csodálatos arcfelismerő szoftvere? Fantasztikus kutatóik vannak, de a fő ok az, hogy több milliárd szelfi van a birtokukban. Miért épített a Google mellékprojektként jobb fordítórendszert, mint a CIA? Több weboldalt kapartak össze, mint bárki más, így több példával rendelkeztek a lefordított dokumentumokról. Az igazi áttörések a gépi tanulásban mindig akkor jönnek, amikor új adathalmazok állnak rendelkezésre. A mélytanulás kis adatmennyiségeken nem sokkal jobb, mint más algoritmusok, de egyre nagyobb és nagyobb adathalmazokon jobban javul, mint bármely más módszer.

Fedezzük fel a gyengeségeit

A mesterséges intelligenciának van egy második előnye is az emberi intelligenciával szemben: tudja, hogy hol van gondja. A legutóbbi Tesla-balesetben a robotpilóta tudta, hogy szokatlan helyzetbe került, és többször is szólt az embernek, hogy vegye át a kormányt. A bank ugyanezt teszi, amikor leolvassa a számokat egy csekkről. Néhány éve a mesterséges intelligencia szinte minden befizetett csekkről leolvassa a számokat, de a különösen rossz kézírású csekkeket még mindig átadják egy embernek felülvizsgálatra. És több mint tizenöt évvel azután, hogy Deep Blue legyőzte Kaszparovot, még mindig vannak olyan helyzetek, amikor az ember le tudja győzni a számítógépet sakkban.

Ha jól csinálják, akkor az ember a rendszerben tartása mindkét világból a legjobbat nyújtja: az automatizálás teljesítményét és költségmegtakarítását, a gépi tanulás néha tapasztalható megbízhatatlansága nélkül. Egy kombinált rendszer megbízhatóbb lehet, mivel az emberek és a számítógépek nagyon különböző hibákat követnek el. A siker kulcsa az emberek és a számítógépek közötti okos átadás-átvétel, ami új típusú interfészeket igényelhet a relatív erősségek és gyengeségek hatékony kihasználásához. Végül is, mit ér egy majdnem tökéletes önvezető autó mesterséges intelligenciája, amely átadja az irányítást egy olyan embernek, akit hagyott elaludni?